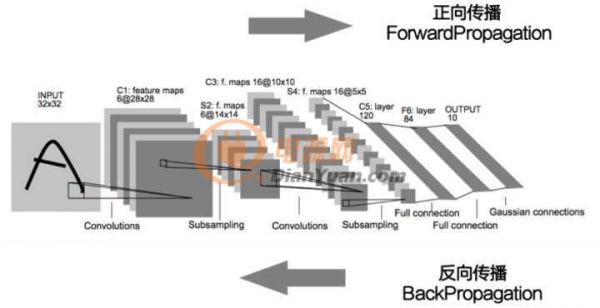

反向传播/梯度下降

既然讲到机器学习,那当然是让机器自己去通过数据去学习,那机器是如何进行自学习的呢?下面就要敲黑板,划重点了,因为这就是深度学习的重中之重了,也就是机器学习的核心了,理解了这个概念,基本上就理解了一多半了。

这个概念就是反向传播。听名字比较玄乎,其实这个概念大家在高等数学里都接触过这个概念了——梯度,其实也就是求导。

对于一维函数而言,函数梯度下降的方向就是导数的反方向。

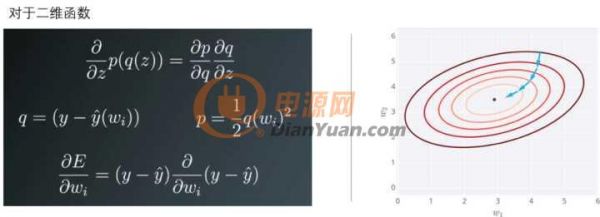

对于二维函数而言,就是把误差对每个变量求偏导,偏导的反方向即为梯度下降的方向。

说起来有点抽象,我们举个实例来说明一下。

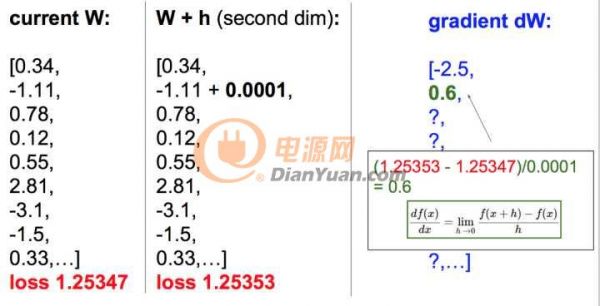

下面是我们的参数和损失函数的值。

我们先对第一个参数加一个极小值,算出新的损失函数。

然后用损失函数的变化去除这个极小值,就是这个参数的梯度了。

同样我们可以使用同样的方法去求得其他参数的梯度。

只要找到梯度下降的方向,按照方向去优化这些参数就好了。这个概念就是梯度下降。

但是我们知道,我们要训练的参数非常多,数据量也非常大,经常是百万、千万量级的,如果每次都把全部训练数据都重新计算一遍,计算损失函数,然后再反向传播,计算梯度,这样下去,模型的误差优化的非常非常慢。

那有没有更快的方法呢?

当然有了。

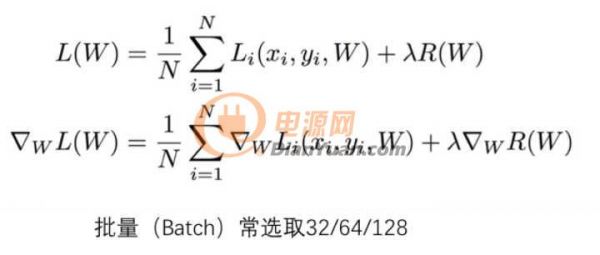

这些参数(weights),数量非常多,大概有上百万个,为了保证能够更好、更快的计算,节省算力,一般选用随机梯度下降方法,随机抽取一定数量(即为批量,batch)的样本,去计算梯度值,一般选择32/64/128。

这个方法就是随机梯度下降,这个批量(batch)这也是大家经常要调的参数。

我们可以这样理解随机梯度下降,其核心思想是,梯度是期望。期望可使用小规模的样本近似估计。具体而言,在算法的每一步,我们从训练集中均匀抽出小批量样本来代替全部数据的梯度,因为其梯度期望是一致的。

值得一提是:这些batch中的样本,必须是随机抽取的,否则其期望就准确了。选的批量(batch)的值越小,进行一次参数优化的计算量越小,就越快,但是其随机性会比较大一些,如果选取的批量值比较大,则计算会稍微慢一些,但是随机性会小一些,这是我们需要权衡的。

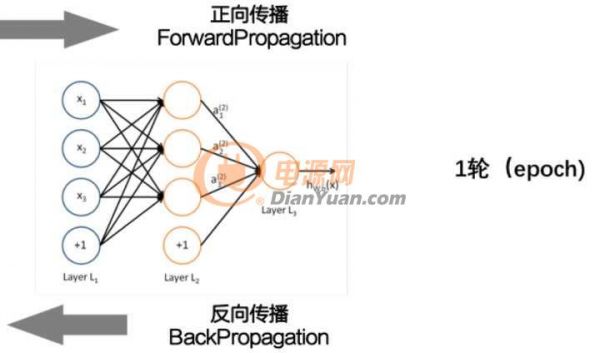

前向计算一次,反向反馈一下,更新一下参数,叫做一个Epoch.

Epoch的次数也是个超参数,也是需要搭建模型的时候可以调整的参数。

在整个模型中也是类似的。

简单总结下,截止到目前,我们已经了解了一些深度学习的基本概念,比如什么是卷积神经网络,了解了反向传播的传播的概念,如何梯度下降的方法去优化误差。

基本上深度学习是什么回事,大家已经知道了,但是深度学习还需要注意一些细节。有句话说的好,细节就是魔鬼,细节处理的好坏很大程度上决定了你是一个高手,还是一个菜鸟。

深度学习之高手进阶

我们在进行深度学习的时候一般会按照这4个步骤进行。

获取数据

很大程度上,数据的多少决定模型所能达到的精度。再好的模型,没有足够数据,也是白瞎。

对于监督学习而言,需要大量标定的数据。

数据的获取是有成本的,尤其是我们需要的数据都是百万、千万量级的,成本非常高。亚马逊有个专门发布标定任务的平台,叫做Amazon Mechanical Turk.

很多大的数据,比如IMAGENET就是在这上面做label的。

Amazon从中抽取20%的费用,也就是说,需求方发布100美元的任务,得多交20美元给Amazon,躺着也挣钱。

由于数据的获取是有成本的,而且成本很高的。

所以我们需要以尽量低的价格去获得更多的数据,所以,在已经获得数据基础上,仅仅通过软件处理去扩展数据,就是非常重要的,常见的数据扩展的方法见下图。

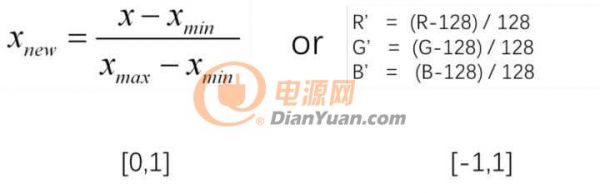

数据预处理-归一化

为了更好的计算数据,避免出现太大或者太小的数据,从而出现计算溢出或者精度失真,一般在开始做数据处理之前,需要进行归一化处理,就是将像素保持在合理的范围内,如[0,1]或者[-1,1]。

模型搭建

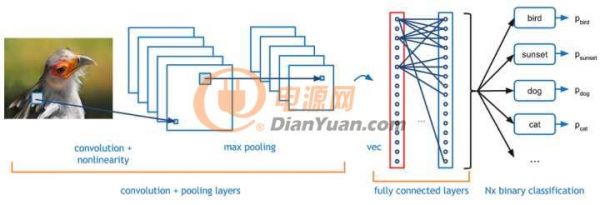

除了上面提到的卷积神经网络之外,我们在搭建模型的时候,还需要一些其他层,最常见的是输出控制。

全连接层Fully-connected

全连接层,其字面意思就是将每个输入值和每个输出值都连接起来,全连接层的目的其实就是控制输出数量。

比如我们最终分类是有10类,那我们需要把输出控制为10个,那就需要一个全连接层来链接输出层。

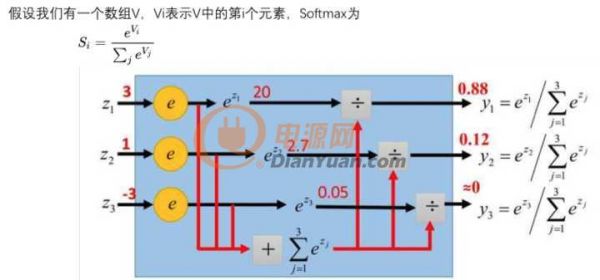

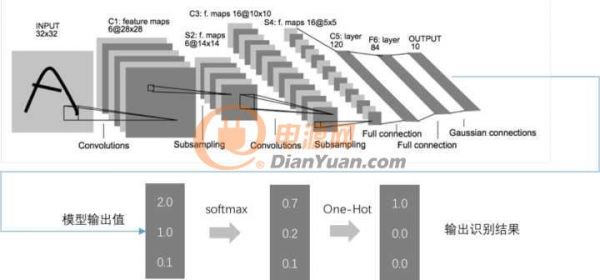

softmax

我们用数值来表征其可能性大小,数值越大,其可能性越大,有的值可能很大,有的值可能很小,是负的。

怎么用概率来表征其可能性呢?总不能加起来一除吧,但是有负数怎么办呢?全连接之后,我们每个类别得到一个值,那怎么转化表征其可能性的概率呢?我们一般通过softmax来转化。

softmax的目的就是把数值转化给每个标签的概率,就是将最终各个值的得分,转化成各个输出值的概率。

独热编码 One-Hot Encoding

独热编码,又叫做一位有效编码。

有多少标签,就转化为多少行的单列矩阵,其本质就是将连续值转化为离散值。

这样可以直接直接将输出值直接输出,得到一个唯一值。

就像一个筛子,只留一个最大值,其他全部筛掉。

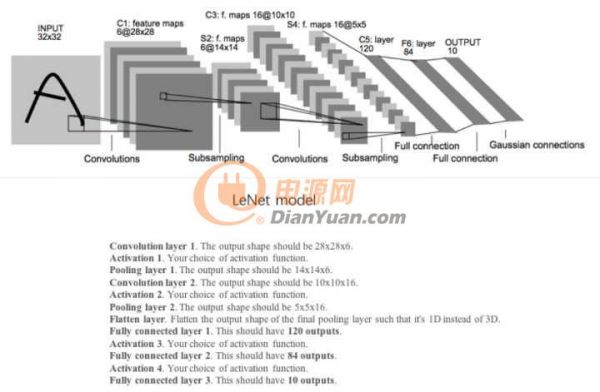

我们以LeNet为例串起来看(见下图),输出值经过全连接层,转化为10个标签值,然后经过softmax和one-hot

encoding,最终转化为唯一的识别标签值,就是我们想要的结果。

客观评价——交叉验证

讲完输出控制,我们再讲一下评价方法。

我们有一些数据,希望利用现有的数据去训练模型,同时利用这些数据去评价这个模型的好坏,也就是我们需要知道,这个模型的准确率是50%,还是90%,还是99%?

具体怎么去做呢?

最先想到的是,用全部的数据去训练,然后评价的时候,从中抽取一定数量的样本去做验证。这不是很简单嘛?

但是,这样不行。

想像一下,在高考考场上,你打开试卷,看了一眼之后高兴坏了。因为你发现这些试题你之前做练习的时候都做过。

其实是一个道理。如果拿训练过的数据去做验证,那得到的误差率会比实际的误差率要低得多,也就失去了意义。

那怎么办呢?我们需要把训练数据和最终评价的数据(也就是验证数据)要分开。这样才能保证你验证的时候看的是全新的数据,才能保证得到的结果是客观可靠地结果。所以我们会得到两个误差率,一个是训练集的误差率,一个是验证集的误差率,记住这两个误差率,后面会用到。

拿到数据的第一步,先把所有的数据随机分成两部分:训练集和验证集。一般而言,训练集占总数据的80%左右,验证集占20%左右。

训练的时候,随机从训练集中抽取一个批量的数据,去训练,也就是一次正向传播和一次反向传播。

这一轮做完之后,从验证集里随机抽取一定数量来评价下其误差率。

每做一轮学习,一次正向传播一次反向传播,就随机从验证集里抽取一定数量数据来评价其模型的准确率,一轮之后我们获得训练误差率和验证误差率。

接下来就是重点了,就是模型训练。

模型训练

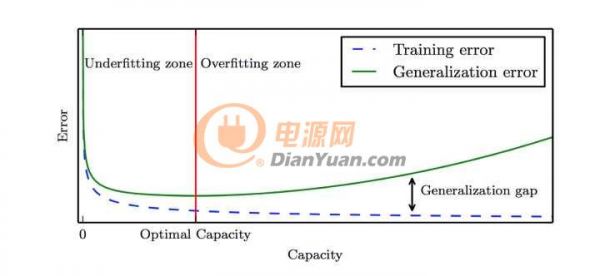

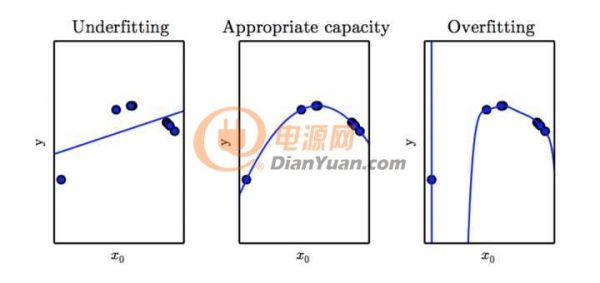

实际训练模型的时候,我们会碰到两大终极难题,一个是欠拟合,一个是过拟合。

所谓欠拟合,就是训练误差率和验证误差率都很高。

所谓过拟合,就是训练集的误差率很低,但是验证集的误差率很高。

欠拟合和过拟合其实跟模型的复杂程度有很大的关系。

比如这张图里面,本来是抛物线的数据,如果用线性模型去拟合的话,效果很很差。如果用9次方模型去拟合的话,虽然训练集表现非常好,但是测试新数据的时候,你会发现表现很差。

欠拟合的原因其实比较简单,就是模型的深度不够,只需要把模型变得复杂一些就能解决。

过拟合的原因就比较多了,一般来说,简单粗暴的增加训练集的数量就能解决这个问题,但是有时候受限于客观条件,我们没有那么多数据。这时候我们就需要调整一些参数来解决过拟合的问题了。

模型中能调整的参数叫做超参数。

调整这些参数,有时候有道理,有时候又没有道理,更多的是靠的一种感觉。所有有人说,调整超参数更像是一项艺术。

常见的调整的超参数有以下几种,下面我们逐项介绍一下。

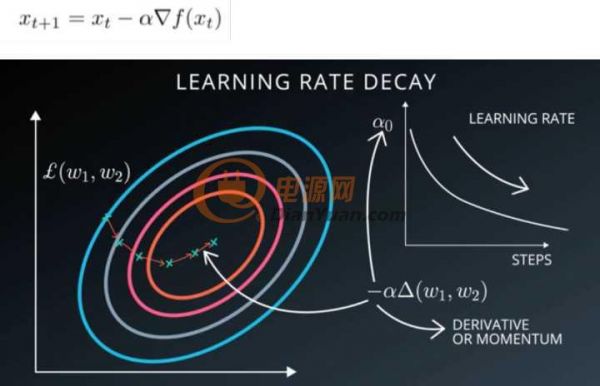

学习率

上面提到的随机梯度下降中,我们会在梯度的前面加一个系数,我们管它叫做学习率,这个参数直接影响了我们误差下降的快慢。

当我们遇到问题的时候,先尝试调整下学习率,说不定就能解决问题。

选择一个合适的学习率可能是困难的。学习率太小会导致收敛的速度很慢,学习率太大会妨碍收敛,导致损失函数在最小值附近波动甚至偏离最小值。下面这张图比较好的说明了学习率高低对模型误差下降的影响。

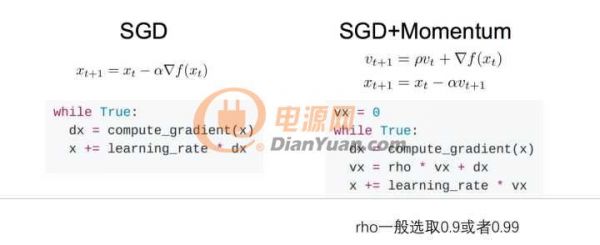

冲量Momentum

冲量的概念其实就是在梯度下降的时候,把上次的梯度乘以一个系数pho,加上本次计算的梯度,然后乘以学习率,作为本次下降用的梯度。pho一般选取0.9或者0.99。其本质就是加上了之前梯度下降的惯性在里面,所以叫做冲量。

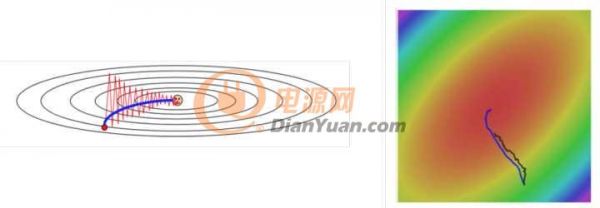

有时候会采用冲量(momentum)能够有效的提高训练速度,并且也能够更好的消除SGD的噪音(相当于加了平均值),但是有个问题,就是容易冲过头了,不过总体来说,表现还是很不错的,一般用的也比较多。

下面这两张图也能看出来,SGD+冲量能够有效的加快优化速度,还能够避免随机的噪音。

轮数epochs

前面提到,一次正向传播,一次反向传播就是一轮,也就是一个epoch。

一般来说,轮数越多,其误差会越好,但是当学习的越多的时候,他会把一些不太关键的特征作为一些重要的判别标准,从而出现了过拟合。如果发现这种情况(下图),我们需要尽早停止学习。

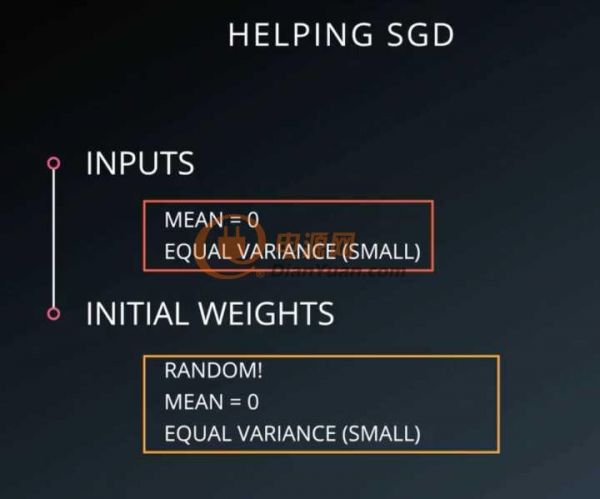

参数初始化(weights initialization)

对于模型的所有参数,我们均随机进行初始化,但是初始化的时候我们一般会让其均值为0,公差为sigma,sigma一般选择比较大,这样其分散效果比较好,训练效果也比较好。

但是有时候仅仅调整超参数并不能解决过拟合的问题,这时候我们需要在模型上做一些文章,在模型上做一些处理,来避免过拟合。

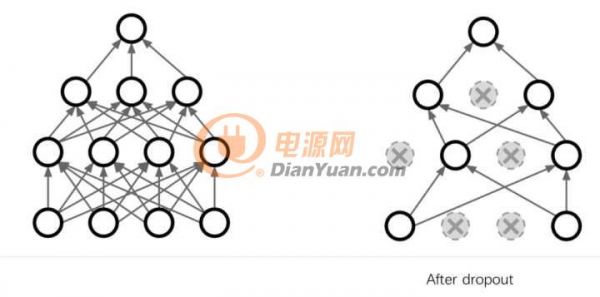

Dropout

最常见的方法就是dropout.

drop的逻辑非常简单粗暴,就是在dropout过程中,有一半的参数不参与运算。

比如说公司里,每天随机有一般人不来上班,为了正常运转,每个岗位都需要有好几个人来备份,这样公司就不会过于依赖某一个人,其实是一个道理。

dropout的本质是冗余。为了避免过拟合,我们需要额外增加很多冗余,使得其输出结果不依赖于某一个或几个特征。

Pooling池化

除此之外,池化也是比较常用到的。

Pooling主要的作用为降维,降维的同时能够保留主要特征,能够防止过拟合。

Pooling主要有两种:一种是最大化Pooling,还有一中是平均池化。

最大池化就是把区域的最大值传递到下一层(见下图),平均池化就是把区域内的平均值传递到下一层。

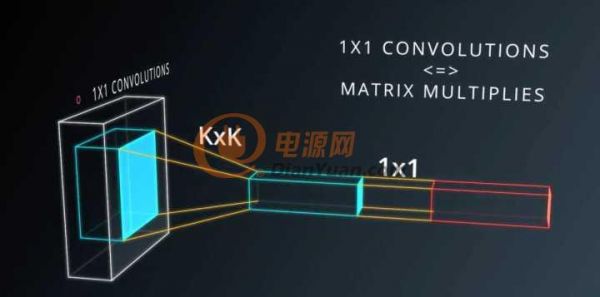

一般在Pooling之后会加上一个1x1的卷积层,这样能够以非常低的成本(运算量),带来更多的参数,

更深的深度,而且验证下来效果也非常好。

接下来我们可以分析下Lenet的数据,看的出来是卷积—>池化—>卷积—>池化—>平化(Flatten,将深度转化为维度)—>全连接—>全连接—>全连接。

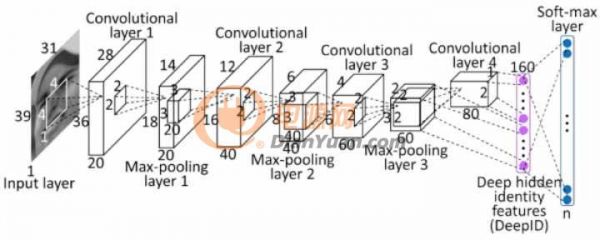

下面这个模型也比较简单,经过多层卷积、池化之后,平化,然后经过softmax转化。

截止到目前,我们又了解了训练模型所需要的技巧,如获取数据、预处理数据、模型搭建和模型调试,重点了解了如何防止过拟合。

恭喜你,现在你已经完全了解了深度学习的全部思想,成功晋级成深度学习高手了~

接下来我们看下深度学习的发展趋势。

深度学习发展趋势

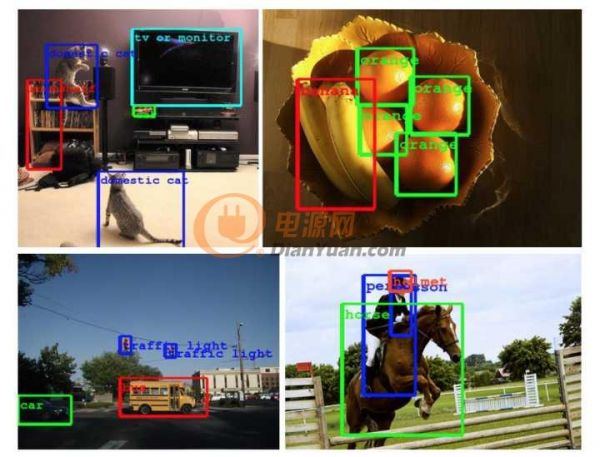

目前深度学习在图像识别领域取得了很多突破,比如可以对一张图片多次筛选获取多个类别,并标注在图片上。

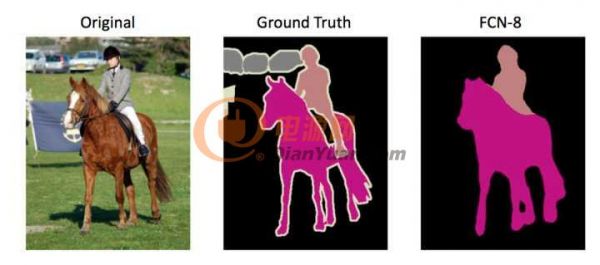

还可以进行图像分割。

在做图像分割标注的时候,难度很大,需要把每个类别的范围用像素级的精度画出来。这对标注者的素质要求很高。

还可以根据图像识别的结果直接生成语句。

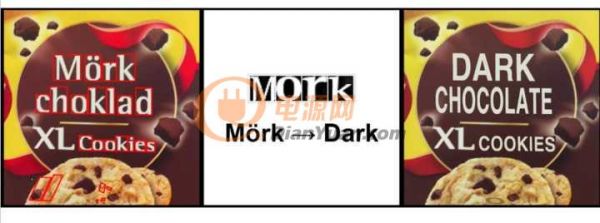

Google翻译可以直接将图片上的字母翻译过来,显示在图片上,很厉害。

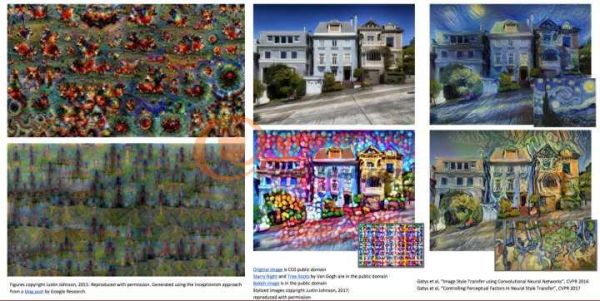

最近媒体上很多新闻,说人工智能可以作诗,写文章,画画等等,这也都是比较简单的。

但是当前图像识别领域还存在一些问题,最大的就是其抗干扰能力比较差。

下图中左侧的图片为原始图片,模型可以轻易识别,但是人工加上一些干扰之后,对于肉眼识别不会造成干扰,但是会引起模型的严重误判。

这种情况可能会在某些很重要的商业应用中带来一些风险,比如在自动驾驶的物体识别时,如果有人故意对摄像头造成干扰,就会引起误判,从而可能会引起严重后果。

深度学习在自动驾驶领域有比较多的应用。

下图为加特纳技术曲线,就是根据技术发展周期理论来分析新技术的发展周期曲线(从1995年开始每年均有报告),以便帮助人们判断某种新技术是否采用。其把技术成熟经过5个阶段:1是萌芽期,人们对新技术产品和概念开始感知,并且表现出兴趣;2是过热期,人们一拥而上,纷纷采用这种新技术,讨论这种新技术;3是低谷期,又称幻想破灭期。过度的预期,严峻的现实,往往会把人们心理的一把火浇灭;4是复苏期,又称恢复期。人们开始反思问题,并从实际出发考虑技术的价值。相比之前冷静不少;5是成熟期,又称高原期。该技术已经成为一种平常。

当前机器学习和自动驾驶就处在过热期。

说到底,人工智能其实就是一种工具而已,只不过这项工具能做的事情多了一些而已。

未来人工智能会融入到生活中的方方面面,我们不可能阻挡这种趋势,所以我们唯一能做的,就是好好利用好这个工具,让未来的工作和生活更加方便一些。

关于人工智能威胁论

当前有些媒体在肆意宣扬人工智能威胁论,这其实是毫无道理的。

当人类对自己不了解的事物会本能的产生恐惧,越是不了解,越是会产生恐惧。

大家今天看下来,是不是也觉得人工智能也没啥。

其实就是因为了解了,所以才不会恐惧。我们只有了解他,才能更好的利用好它。

当前有部分无良媒体以及所谓的专家,在传播人工智能威胁论。

其实所谓的专家根本就不是这个领域的专家,如果他不是这个领域的专家,那他对这个话题其实就没有话语权,他说话的分量就跟一个普通人说的没什么区别。

流传比较广的,比如说某个坐在轮椅上获得过诺贝尔物理学奖的英国物理学家,对,没错,我说的就是霍金。

还有某国际著名新能源汽车公司的CEO,对,我说的就是Elon Musk。

他们对人工智能其实也完全是一知半解。

大家今天听完之后,对人工智能的理解就可以秒杀他们了。

最近看到吴军的一句话,来解释这个人工智能威胁论,觉得非常恰当。

总结一下人工智能的边界。1. 世界上有很多问题,其中只有一小部分是数学问题;2. 在数学问题中,只有一小部分是有解的;3. 在有解的问题中,只有一部分是理想状态的图灵机可以解决的;4. 在后一类的问题中,又只有一部分是今天实际的计算机可以解决的;5. 而人工智能可以解决的问题,又只是计算机可以解决问题的一部分。

来自: 幸运符hjssc716 > 《人工智障》

声明:本内容为作者独立观点,不代表电源网。本网站原创内容,如需转载,请注明出处;本网站转载的内容(文章、图片、视频)等资料版权归原作者所有。如我们采用了您不宜公开的文章或图片,未能及时和您确认,避免给双方造成不必要的经济损失,请电邮联系我们,以便迅速采取适当处理措施;欢迎投稿,邮箱∶editor@netbroad.com。